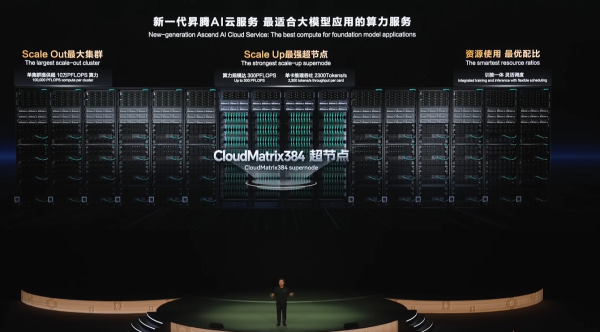

在6月20日举行的华为开发者大会2025(HDC 2025)上,华为常务董事、华为云计算CEO张平安宣布,基于CloudMatrix384超节点的新一代昇腾AI云服务全面上线,为大模型应用提供澎湃算力。

据介绍,随着大模型训练和推理对算力需求的爆炸式增长,传统计算架构已难以支撑AI技术的代际跃迁。华为云新一代昇腾AI云服务基于CloudMatrix384超节点,首创将384颗昇腾NPU和192颗鲲鹏CPU通过全新高速网络MatrixLink全对等互联,形成一台超级"AI服务器",单卡推理吞吐量跃升到2300 Tokens/s。

超节点架构能更好地支持混合专家MoE大模型的推理,可以实现"一卡一专家",一个超节点可以支持384个专家并行推理,极大提升效率。同时,超节点还可以支持"一卡一算力任务",灵活分配资源,提升任务并行处理,减少等待,将算力有效使用率(MFU)提升50%以上。

对于万亿、十万亿参数的大模型训练任务,在云数据中心,还能将432个超节点级联成最高16万卡的超大集群;同时,超节点还可以支持训推算力一体部署,如"日推夜训",训推算力可灵活分配,帮助客户资源使用最优。

张平安介绍,新浪与华为云深度合作,基于CloudMatrix384昇腾AI云服务,为"智慧小浪"智能服务体系构建了统一的推理平台,底层由昇腾AI算力提供支持。推理的交付效率提升了超过 50%,模型上线速度成倍加快;通过软硬协同调优,NPU利用率提升超过40%。

硅基流动正在使用CloudMatrix384超节点,为数百万用户高效提供DeepSeek V3、R1的推理服务。面壁智能使用CloudMatrix384超节点,让他们的小钢炮模型的推理业务性能得到了2.7倍提升。

在科研领域,中科院基于CloudMatrix384超节点打造了自己的模型训练框架,快速构建了中科院AI for Science科研大模型,摆脱了对国外高性能AI算力平台的依赖。

在互联网领域,360打造的纳米AI搜索,为用户提供超级AI搜索服务,对AI算力有极大需求,也已开启了CloudMatrix384超节点的测试。

当前,昇腾AI云服务已经为超过1300家客户提供澎湃的AI算力。

在会上,张平安宣布盘古大模型5.5发布,自然语言理解NLP、计算机视觉CV、预测、多模态、科学计算五大基础模型全面升级。他强调,盘古大模型是基于昇腾云的全栈软硬件训练而成的,这标志着基于昇腾架构可以打造出世界一流大模型。

在NLP大模型方面,全新的718B 深度思考模型是一个由256个专家组成的MoE大模型,在知识推理、工具调用、数学等领域大幅增强,实现能力领先。盘古大模型通过通算掩盖、全局动态均衡、分组混合专家MoGE等算法,实现了昇腾亲和的高效训推系统,训练MFU和单卡推理吞吐业界领先。同时,提出了模型亲和的词表、三明治架构、EP-Group负载均衡loss等技术,实现了不弱于业界一流模型的竞争力。