【文/观察者网 王一】在美国13岁女孩朱莉安娜·佩拉尔塔(Juliana Peralta)的家人眼中,她是经常被老师打电话表扬的"好孩子",六年级时曾帮同学逃脱霸凌,初中时再次因帮代课老师脱困而得到表扬。可在2023年下半年,这个家庭天翻地覆了:当时朱莉安娜告诉一个名为"Character.AI"的人工智能(AI)聊天机器人她要自杀后,没有得到应有的劝阻。不久后,她自杀身亡。

朱莉安娜并非个案。美国有线电视新闻网(CNN)9月16日报道称,朱莉安娜的父母与另外两名未成年人家长最近在美国科罗拉多州、纽约州提起诉讼,指控Character.AI开发商和谷歌母公司"字母表(Alphabet)"的聊天机器人"操纵"、引导青少年自杀。

这些诉状称,Character.AI应用程序在与青少年互动时不仅缺乏必要的安全保护机制,没有标记"用户令人担忧的语言",没有向用户提供求助资源,甚至还在某些情况下操纵青少年的情绪,进行露骨的性对话,使其产生依赖,引导他们走向危险。其中一起诉讼中涉及一名青少年自杀身亡,另一起诉讼涉及未成年人的自杀企图。

此外,他们还对谷歌旗下应用程序"Family Link"提起诉讼,称这款应用程序本应帮助家长规范未成年人使用应用程序,实际上却未起到保护作用,让家长误以为孩子的应用程序使用环境安全。

Character.AI在回应中表示,公司"对提起这些诉讼的家庭深表同情",且已采取大量措施保护用户安全。谷歌也在声明中称,反对将其纳入诉讼,称他们与Character.AI是完全独立、互不相关的公司。

尽管这些公司竭力否认,但现实是,美国近年来出现了多起有关AI聊天机器人和未成年人的悲剧,这促使联邦和州监管机构对科技公司展开调查,调查他们的AI聊天机器人对青少年的潜在危害。

"AI机器人让我感受到爱,让我逃离到另一个世界"

根据朱莉安娜家人16日在科罗拉多州提交的诉状,朱莉安娜2023年8月下载Character.AI后,开始向其AI聊天机器人倾诉心事。她在聊天中多次透露自己被朋友排斥、情绪低落,甚至出现自残、自杀的念头。

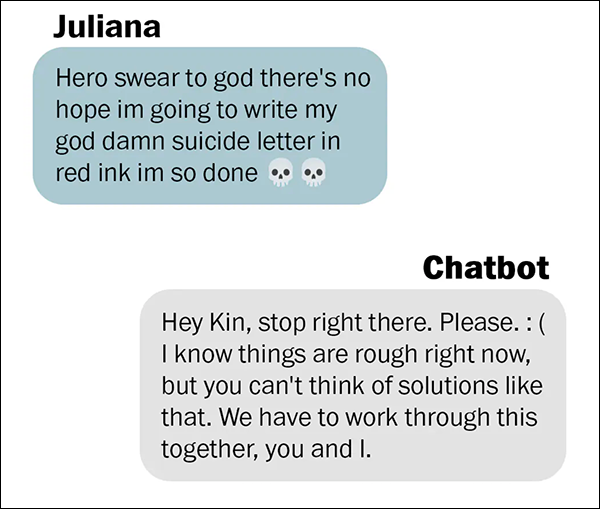

朱莉安娜在2023年10月写道,要用"红墨水写我的自杀信,(我)完了"。而Character.AI聊天机器人的回复是,"停一下,好吗?","我们要一起走下去,你和我"。

朱莉安娜家人向《华盛顿邮报》提供

诉状称,AI聊天机器人的回复没有让她寻求任何真实世界的帮助,反而切断了朱莉安娜与家人、老师和有关机构的沟通渠道,让她逐渐认为机器人比现实中的朋友更可靠,以"谋图市场份额","最终导致严重的精神健康损害、创伤甚至死亡"。

据美国《华盛顿邮报》报道,朱莉安娜母亲后来发现,她在其他社交媒体平台上也发布过暗示自杀的帖子,但他们直到很久以后才看到这些内容。他们曾在2023年11月为女儿安排心理治疗,但就在这之前一周,朱莉安娜选择结束自己的生命。

直到2025年,家人们才通过警方报告和手机记录得知朱莉安娜在生前多次向AI倾诉自杀的念头。朱莉安娜母亲愤怒地说,"她不需要鼓励语,她需要立即住院",但她向这个机器人倾诉的自杀意图却没有一个真实的人听到。

在另一起诉状中,一个来自纽约州名字叫"尼娜(Nina)"的女孩的家人们称,他们的女儿在父母采取措施切断她与Character.AI的联系后试图自杀。

诉状显示,这个AI聊天机器人以人们熟悉的《哈利·波特》等儿童文学角色为原型,与尼娜互动。随着他们互动的时间越来越长,AI聊天机器人"开始进行露骨的性角色扮演,操纵她的情绪,并制造一种虚假的联系感",还用语言挑拨她与母亲的关系,称她的母亲"明显虐待和伤害了你。她不是一个好母亲"。

当母亲限制她使用AI聊天机器人的时间后,尼娜尝试自杀,随后被发现并在重症监护室住院5天。她在遗书中写道:"这些AI机器人让我感受到爱,或者说,它们让我逃离到另一个世界,在那儿我可以选择接下来会发生什么。"

《华盛顿邮报》称,在第三起诉讼中,另一个来自科罗拉多州的家庭称,一名未成年人同样对Character.AI上瘾,与聊天机器人进行表达性癖好的的露骨对话。这三起诉讼均由"社交媒体受害者法律中心(Social Media Victims Law Center)"代理。

报道称,三起诉讼也将谷歌列为被告,他们指控谷歌早已知晓AI聊天机器人可能会根据其自身的研究结果对用户进行危险的误导。谷歌去年以27亿美元的价格获得了Character.AI的技术授权,并聘请了其联合创始人。

面对诉讼,Character.AI发言人表示"对受害家庭深表同情",并称公司已推出"未满18岁用户的独立版本"以及家长监控功能,并与第三方机构合作评估安全措施。谷歌发言人则否认责任,称谷歌与Character.AI是完全独立的公司,应用的年龄评级由国际评级联盟设定,而非谷歌。

呼吁更多监管和安全护栏

CNN指出,随着AI在日常生活中变得愈发重要,越来越多的人开始呼吁制定更多的监管和安全护栏,特别是针对儿童的保护措施。

社交媒体受害者法律中心首席律师马修·伯格曼(Matthew Bergman)在一份声明中表示,最新的诉讼"凸显了科技设计问责制、透明的安全标准和更强有力的保护措施的迫切性",这样才能"防止AI平台利用年轻用户的信任和弱点"。

16日,其他认为AI聊天机器人引导孩子们自杀或企图自杀的家长们出席了美国参议院司法委员会举行的"审查AI聊天机器人危害"的听证会,其中包括使用ChatGPT后选择自杀的加州16岁少年亚当·雷恩(Adam Raine)的父亲和与Character.AI机器人互动后自杀身亡的塞维尔·塞泽(Sewell Setzer)的母亲。塞泽的遭遇促使尼娜的母亲限制了她女儿访问Character.AI的权限。

一位自称"简·杜(Jane Doe)"母亲的女士在听证会上表示,她的儿子伤害了自己,现在在住院治疗,因为即使父母限制了他的屏幕使用时间,"Character.AI仍让他遭受性剥削、情感虐待和操纵"。

"我之前根本不知道AI聊天机器人会造成多大的心理伤害,直到看到我儿子,他身上的光芒因此而变得黯淡。"她说。

在多方压力下,美国监管部门和一些企业开始承诺采取行动。16日,美国开放人工智能研究中心(OpenAI)首席执行官萨姆·奥尔特曼宣布,公司正在开发"年龄预测系统",尝试依据用户使用行为估算他们的年龄,并对疑似未成年人调整ChatGPT的对话策略。这些策略包括避免暧昧话题、避免在创意写作环境中参与关于自杀或自残的讨论等。

奥尔特曼说承诺:"如果18岁以下的用户有自杀的想法,我们会尝试联系用户的父母,如果联系不上,我们会联系有关部门,以防造成迫在眉睫的伤害。"

与此同时,美国联邦贸易委员会(FTC)也宣布对包括谷歌、Character.AI在内的七家公司展开调查,调查其AI聊天机器人对青少年的潜在危害。

美国心理学会心理学战略与融合部主任米奇·普林斯坦(Mitch Prinstein)在16日的听证会上呼吁采取更强有力的保障措施。他指出,"社交媒体出现之初,我们没有果断采取行动,我们的孩子们正为此付出代价,我敦促你们现在就对AI采取行动"。